警惕AI“假声”电骗

2023-05-17 富美财经 浏览量:次

图:在网上平台,有不少用人工智能翻唱经典歌曲的片段。 除了被彻底洗脑式的电骗案,AI“假声”亦会成为骗徒犯案的工具。近期YouTube频道上载不少AI“假声”的影片,翻唱多位歌星的名曲,声调几可乱真,可见现时要假扮谁人的声音并没有难度。 香港资讯科技商会荣誉会长方保侨提醒,AI“假声”的电骗案将会盛行,市民更需要提高警觉。方保侨表示,骗徒利用偷录了某人的声音,经AI解读及分析后,可从声音样本模拟发声,模仿声调作为犯罪的工具,读出骗徒行骗的内容。他又称,如骗徒已掌握受害人亲友的声音,受害人更易受骗,“如骗徒曾致电受害人的亲人倾谈,讲了一大段说话,被骗徒偷录下来,AI便会分析相关语调及声调,再利用相关‘声音’作出诈骗。” 模仿受害者儿子声音骗财 方保侨又指市民遇不明来电务必小心,并需核实对方相关讯息的真伪,“很多时骗徒得知受害人对亲人的安危十分着急,在心急的情况下,没有即时核实。”他称现时AI生成的声音较“生硬”及“粗糙”,细心聆听可以辨别,惟当受害人焦急,便较易误堕陷阱。 事实上,AI“假声”电骗案已发生。一名骗徒三月致电一对加拿大夫妇,利用AI模仿其儿子的声音,及后成功骗取2.1万加元(约12万港元)。骗徒在电话上利用以AI合成其儿子的“声线”致电该对夫妇表示,“儿子”驾车撞死一名美国外交官,现身处监狱,急需金钱支付律师费。数小时后骗徒又再佯称是其儿子代表律师致电,声称开庭前需要2.1万加元。 此外,去年十二月,台湾警方首次破获一个结合AI语音机械人行骗的诈骗集团,拘捕2人。当中最少40名受害人报警,损失合共1亿元新台币(约2,527万港元),其中一名六旬妇人被骗金额最高,达2,300万元新台币(约581万港元)。

图:在网上平台,有不少用人工智能翻唱经典歌曲的片段。 除了被彻底洗脑式的电骗案,AI“假声”亦会成为骗徒犯案的工具。近期YouTube频道上载不少AI“假声”的影片,翻唱多位歌星的名曲,声调几可乱真,可见现时要假扮谁人的声音并没有难度。 香港资讯科技商会荣誉会长方保侨提醒,AI“假声”的电骗案将会盛行,市民更需要提高警觉。方保侨表示,骗徒利用偷录了某人的声音,经AI解读及分析后,可从声音样本模拟发声,模仿声调作为犯罪的工具,读出骗徒行骗的内容。他又称,如骗徒已掌握受害人亲友的声音,受害人更易受骗,“如骗徒曾致电受害人的亲人倾谈,讲了一大段说话,被骗徒偷录下来,AI便会分析相关语调及声调,再利用相关‘声音’作出诈骗。” 模仿受害者儿子声音骗财 方保侨又指市民遇不明来电务必小心,并需核实对方相关讯息的真伪,“很多时骗徒得知受害人对亲人的安危十分着急,在心急的情况下,没有即时核实。”他称现时AI生成的声音较“生硬”及“粗糙”,细心聆听可以辨别,惟当受害人焦急,便较易误堕陷阱。 事实上,AI“假声”电骗案已发生。一名骗徒三月致电一对加拿大夫妇,利用AI模仿其儿子的声音,及后成功骗取2.1万加元(约12万港元)。骗徒在电话上利用以AI合成其儿子的“声线”致电该对夫妇表示,“儿子”驾车撞死一名美国外交官,现身处监狱,急需金钱支付律师费。数小时后骗徒又再佯称是其儿子代表律师致电,声称开庭前需要2.1万加元。 此外,去年十二月,台湾警方首次破获一个结合AI语音机械人行骗的诈骗集团,拘捕2人。当中最少40名受害人报警,损失合共1亿元新台币(约2,527万港元),其中一名六旬妇人被骗金额最高,达2,300万元新台币(约581万港元)。

-

-

优秀!祝贺空军首批“双学籍”女飞

近日由空军和清华大学北京大学联合培养的首批“双学籍”女飞行学员顺利完...

- 国内财经 2024-05-09

-

优秀!祝贺空军首批“双学籍”女飞

-

-

负面情绪正持续发酵 多国计划加强对ChatGPT监管

图为2023年11月7日,在第五届进博会技术装备展区的人工智能专区,体验者借...

- 国内财经 2024-05-09

-

负面情绪正持续发酵 多国计划加强对ChatGPT监管

-

-

强降雨引发洪水 江西安远紧急避险200余户村民

4月5日凌晨,江西赣州安远县遭遇突发恶劣的强降水、雷雨天气,引发洪水,...

- 国内财经 2024-05-09

-

强降雨引发洪水 江西安远紧急避险200余户村民

-

-

第20届中国-东盟博览会新加坡巡展开幕

第20届中国-东盟博览会新加坡巡展暨国际陆海贸易新通道、“桂品出海”开幕...

- 国内财经 2024-05-09

-

第20届中国-东盟博览会新加坡巡展开幕

-

-

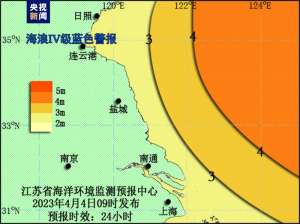

江苏发布海域海浪Ⅳ级蓝色警报

江苏省海洋环境监测预报中心根据《江苏省海洋灾害应急预案》发布江苏海域...

- 国内财经 2024-05-09

-

江苏发布海域海浪Ⅳ级蓝色警报

-

-

印度一百年老树因暴雨倒塌 已致7死30伤

据《印度论坛报》4月10日报道,受到暴雨影响,当地时间4月9日晚,印度马哈...

- 国内财经 2024-05-09

-

印度一百年老树因暴雨倒塌 已致7死30伤